Sans doute nécessaire mais devant absolument être contrôlée, comment appréhender la modération des contenus sur internet ?

Depuis la parution du livre que Romain Badouard leur avait consacré, Les nouvelles lois du web (Seuil/République des Idées, octobre 2020), les questions de modération et de censure sur internet n’ont pas cessé de retenir l’attention.

L’auteur y expliquait que, pour se conformer à la loi et montrer leur bonne volonté, les grandes plateformes du web comme YouTube, Facebook ou Twitter ont été amenées à se doter de moyens algorithmiques et humains conséquents pour modérer les contenus, limiter la propagation des fake news et faire barrage aux discours de haine. Ces moyens restent très imparfaits et on peut soupçonner ces plateformes de ne pas vouloir en faire plus pour préserver les très importants revenus publicitaires qu’elles tirent du web. En même temps, les mesures qu’elles prennent en ce sens tombent aussi sous le coup du reproche inverse, c’est-à-dire de trop en faire et de censurer au-delà de ce qui est nécessaire. Elles peuvent alors, en retour, être soumises à des pressions fortes issues de la société civile. Ce qui peut finalement les conduire à vouloir en partager la responsabilité avec des émanations de celle-ci. Pour autant, explique alors Romain Badouard, si on ne veut pas être dupe, il est indispensable de se donner les moyens de contrôler les données que les plateformes acceptent de partager et ce qu’elles veulent bien dire de leur fonctionnement, et cela nécessite une autorité investie par les Etats : la création d’une agence publique et indépendante, qui aurait pour fonction de contrôler l’action des plateformes en matière de régulation des contenus. Romain Badouard a aimablement accepté de répondre à quelques questions pour éclairer son propos.

Nonfiction : Les phénomènes que vous décrivez s’appliquent surtout aux plus grandes plateformes. Faut-il alors selon vous se concentrer sur celles-ci ou faudrait-il aussi contrôler les autres ?

Romain Badouard : Les nouvelles lois et projets législatifs en cours visant à davantage réguler les réseaux sociaux ont en effet tendance à distinguer les « grandes » et les « petites » plateformes, étant entendu que les exigences à l’égard des grandes sont plus importantes. Cette distinction me paraît pertinente : l’enjeu de ces projets est moins de réguler le web dans son ensemble que ses espaces « grand public ». Il y a toujours eu et il y aura toujours de la haine et de la désinformation, en ligne comme ailleurs. Ce qui est en jeu, c’est plutôt leur visibilité. Sur Facebook, Twitter et YouTube, les propos haineux et les fausses informations sont exposés à un grand nombre d’internautes, accompagnant ainsi une logique de « brutalisation » du débat en ligne qui légitime la tenue de tels propos. C’est pour cette raison que les pouvoirs publics doivent se montrer exigeant envers ces acteurs. En revanche, qu’il existe en ligne des espaces de discussion moins régulés, où les expressions sont plus « libres », quelles qu’elles soient, cela semble assez légitime. Car à trop vouloir réguler, on risque effectivement de perdre ce qui faisait d’internet un outil au service de la liberté d’expression des citoyens et des citoyennes.

Vous notez que les discours de haine comme les fake news sont surtout issus d’une « fachosphère » et que la régulation prend ainsi presque nécessairement un tour politique...

Les discours de haine et la désinformation sont effectivement marqués politiquement. Aux Etats-Unis comme en Europe, on se rend compte que les fausses informations politiques, par exemple, sont majoritairement produites par une blogosphère d’extrême droite, qu’on appelle « fachosphère » en France et « alt-right » outre-Atlantique. Pour autant l’extrême-droite n’a pas le monopole de la violence expressive en ligne : la haine en ligne est également très présente du côté des extrémistes religieux, et beaucoup de réseaux pourvoyeurs de « fake news » ne font pas forcément dans la désinformation politique, comme l’illustre l’essor lucratif des réseaux de production de fausses informations de santé. Ceci dit, la régulation des réseaux sociaux est au cœur de questions proprement politiques, et le cas de la suppression des comptes de Donald Trump en début d’année en est un bon exemple. D’un côté, ses partisans crient à la censure politique, de l’autre ses opposants accusent les réseaux sociaux de ne pas avoir agi plus tôt. C’est pour cette raison qu’il faut d’une part des règles claires qui s’appliquent indépendamment des orientations politiques des acteurs, et d’autre part des instances de contrôle des réseaux sociaux, indépendants des plateformes et des pouvoirs publics, qui s’assurent que les activités de modération se fassent dans le respect des lois et du pluralisme démocratique.

Les volumes à traiter sont énormes, est-ce que cela ne pose pas un problème ? On laissera forcément passer beaucoup de choses et les mesures trop compliquées à mettre en œuvre risquent d’être extrêmement coûteuses et finalement peu efficaces. Qu'en pensez-vous ?

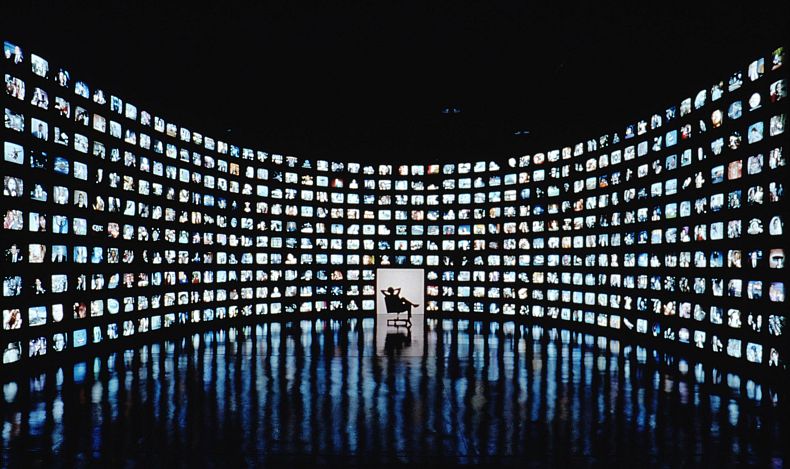

Le volume de publication est effectivement un problème, à partir du moment où on entend réguler l’ensemble des contenus mis en ligne sur ces plateformes. Chaque minute, ce sont des centaines d’heures de vidéos qui sont chargées sur YouTube, des centaines de milliers de tweets qui sont publiés sur Twitter, on parle de plusieurs milliards de publications chaque jour sur Facebook. Pour pallier ce problème d’échelle, les plateformes ont recours à la détection automatique : des outils d’intelligence artificielle scannent les contenus publiés et bloquent ceux qui semblent aller à l’encontre des règles de publication. Le problème de cette dynamique d’automatisation de la modération, à laquelle ont recours de grandes plateformes comme YouTube, Twitter, Facebook (et Instagram), est qu’elle produit également de la censure abusive : les algorithmes de détection sont faillibles et peuvent supprimer des contenus légitimes, ce qui pose des questions importantes en termes de liberté d’expression. Mais on peut aussi contourner le problème en considérant que tous les contenus n’ont pas besoin d’être vérifiés, par exemple en s’intéressant à la viralité des contenus, en observant ceux qui bénéficient d’une plus large audience, ou qui se diffusent rapidement. Une fausse information ou une parole haineuse qui ne sont vues que par quelques personnes n’ont pas le même impact que lorsqu’elles sont vues des milliers de fois.

Faire barrage au discours de haine et ménager la liberté d’expression sont-ils vraiment sur le même plan ? Et si oui comment pourrait-on concilier alors ces deux objectifs ?

Malheureusement, les deux dossiers sont intimement liés. Lutter contre la haine en ligne se traduit concrètement par limiter l’expression de cette haine et donc la bloquer, la supprimer, la contextualiser ou encore limiter sa visibilité. En conséquence, on réduit le champ d’expression des internautes. Mais on peut, d’une part, considérer que la haine en ligne réduit la liberté de parole de celles et ceux qui en sont la cible, et qui intègrent, consciemment ou non, qu’ils et elles feraient mieux de se taire pour ne pas devenir à leur tour victime de cette haine. Au nom d’une vision de « régulation correctrice », on peut ainsi considérer que limiter la liberté des uns, notamment lorsqu’ils incitent à la haine contre des personnes ou des groupes de personnes, c’est permettre la liberté des autres.

D’autre part, il est possible de faire tenir ensemble lutte contre la haine et protection des libertés, notamment en reconnaissant de nouveaux droits aux internautes. Le droit de faire appel par exemple, lorsqu’ils pensent avoir été victimes de censure abusive sur les réseaux, afin de faire réévaluer leurs cas. Il faut également réfléchir à la manière de réinjecter de la justice dans ces processus : en démocratie, ce sont aux juges, à la fois indépendants des plateformes et des états, de trancher les litiges en termes d’abus liés à la liberté d’expression. Or, la justice est globalement absente des projets de régulation mis en œuvre aujourd’hui en Europe, ce qui prolonge une dynamique d’extra-judiciarisation de la régulation des contenus, déjà en œuvre dans le domaine de la lutte anti-terroriste et la protection du droit d’auteur, qui peut s’avérer dangereuse pour nos libertés.